在做出一个决定后,我们会期待出现相应的结果。如果事与愿违,结果与预期不相符合,则意味着先前决定不合适,有必要进行调整。因此,迅速且准确地判断结果与预期的一致性,构成了适应性反应的基础。已有研究发现,结果与预期不一致时在大脑额中部会引发一个负走向的脑电成分,命名为反馈相关负波(feedback-related negativity, FRN)。关于FRN的产生机制主要有强化学习和预期违反两个模型。强化学习认为FRN反映的是结果比预期好还是坏,相对于结果比预期好时,结果比预期差时的FRN波幅更负。预期违反则认为FRN只反映结果是否与预期一致,无所谓好坏;因此,当结果与预期不一致时,更好的结果与更坏的结果所引起的FRN波幅差异不显著。从文献来看,两个观点都获得了实验证据的支持,因此FRN的产生机制尚无定论。

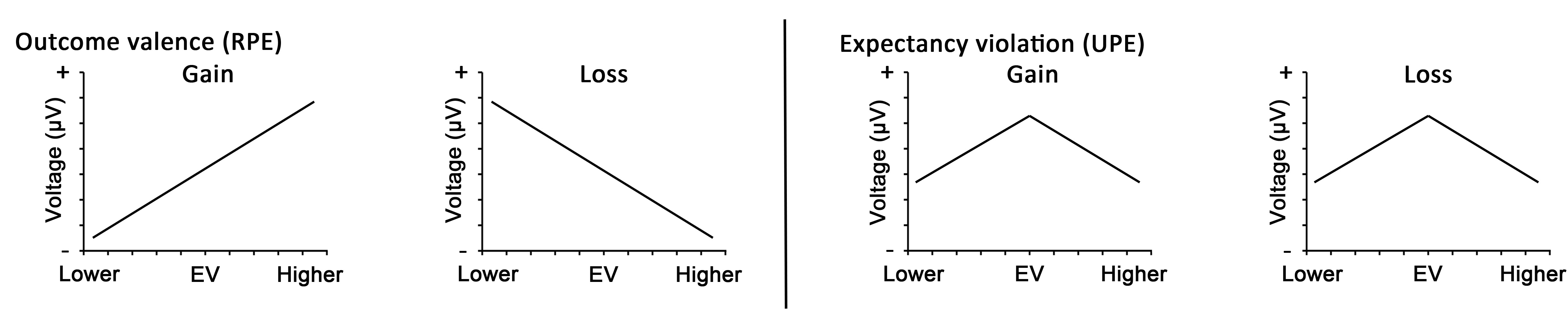

在实际情景中,结果与预期之间的不一致(预期错误)有可能较大,也可能较小,即预期错误实际上是在一定范围内连续变化的。但已有研究一般只设置两个预期错误:比预期好、比预期坏。西南大学心理学部陈安涛教授带领的研究团队提出,有必要对预期错误进行量化处理,获得从较小的预期错误到较大的预期错误的连续变化。在此基础上,研究者根据上述两个模型分别做出预期错误值调节FRN的实验预测。根据强化学习模型,结果比预期越好的FRN波幅越正、结果比预期越坏的FRN波幅越负,二者会以EV(结果与预期一致,即预期错误为0)为中心形成不对称分布(图1左)。相反,根据预期违反模型,无论好坏,结果与预期越不一致就越负,二者会以EV为中心形成对称分布(图1右)。因此,预期错误的量化处理允许研究者严格地检验上述两个模型的预测。

图1:模型预测。在预期错误量化处理背景下,根据强化学习观点所做的预测(左)和根据预期违反观点所做的预测(右)。

在本研究中,预期错误的量化处理是让被试者在每个试次中,确认其预期值(在0到20之间移动光标实现),随后向被试呈现反馈结果(同样是0到20的数字),反馈值减去预期值得到的差值就是他们在该试次中的预期错误值。得益于预期错误量化的实验处理,本研究能够对预期错误值与脑电波幅做单试次相关分析,从而直接地检验上述两个模型的预测。具体来说,将每个试次下的预期错误值与该试次下每个采样点上的ERP波幅求相关,获得一条包含行为信息(即预期错误值)的新波形。为了排除脑电成分相互叠加的问题,在单试次相关分析的基础上,使用PCA(主成分分析)将FRN与其它脑电成分分离,从而获得纯净的FRN成分。然后检查该波形上FRN时间窗口的相关结果,正值波形反映正相关、负值波形反映负相关。在此基础上进一步具体化模型的预测,如强化学习模型为真,则在获益(Gain)条件下,无论预期错误小于0还大于0,预期错误与脑电的相关均为正;而在损失(Loss)条件下,无论预期错误小于0还是大于0,二者的相关均为负(图1左)。如预期违反为真,则无论是获益还是损失条件,预期错误小于0时预期错误与脑电相关均为正,预期错误大小0时二者的相关均为负(图1右)。

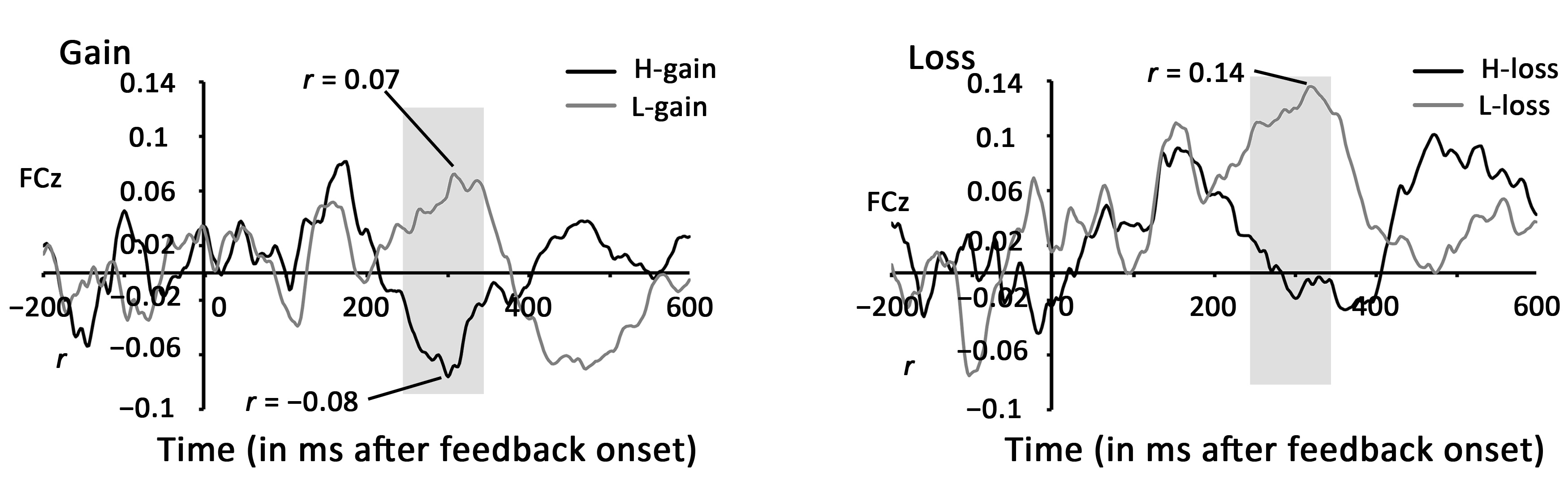

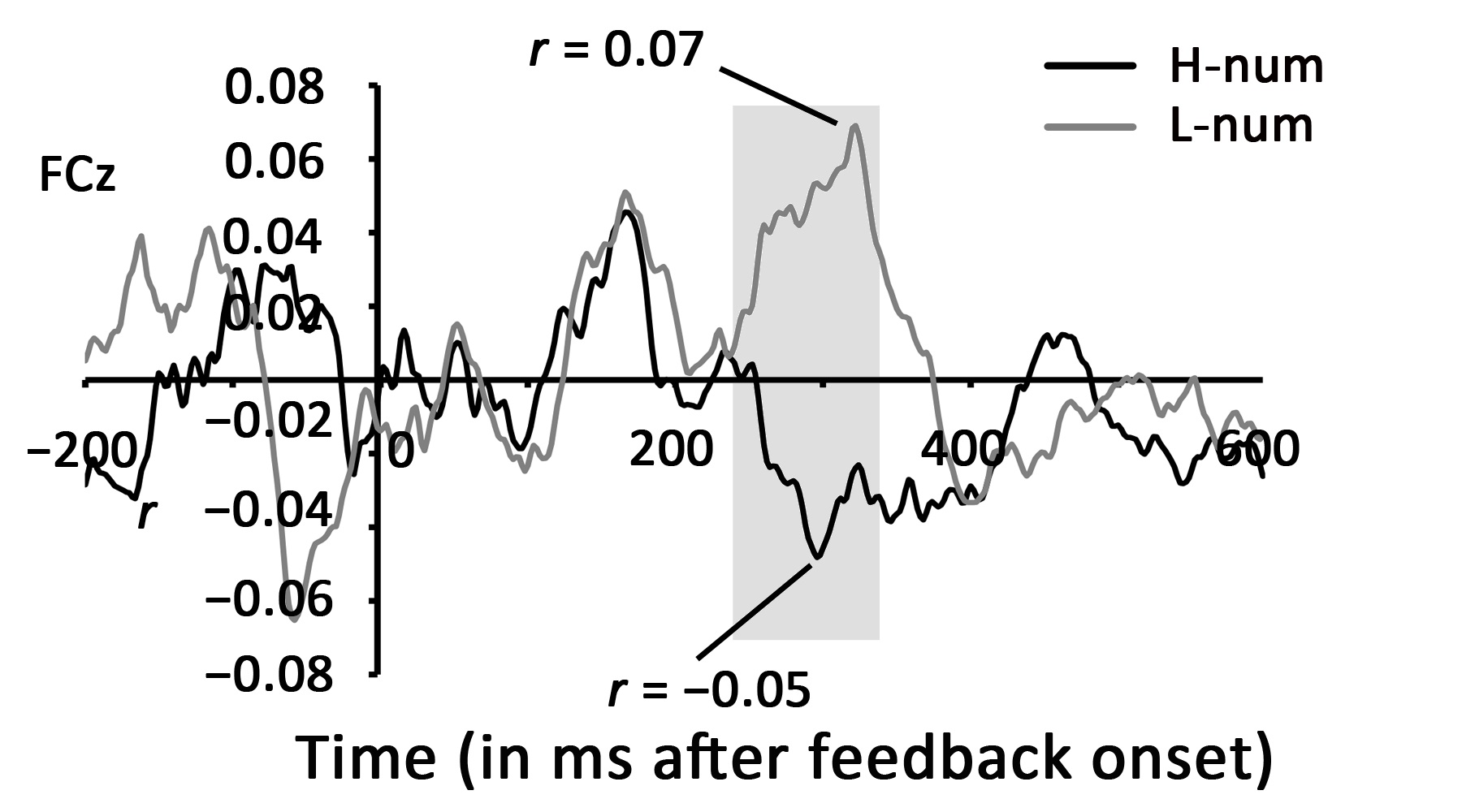

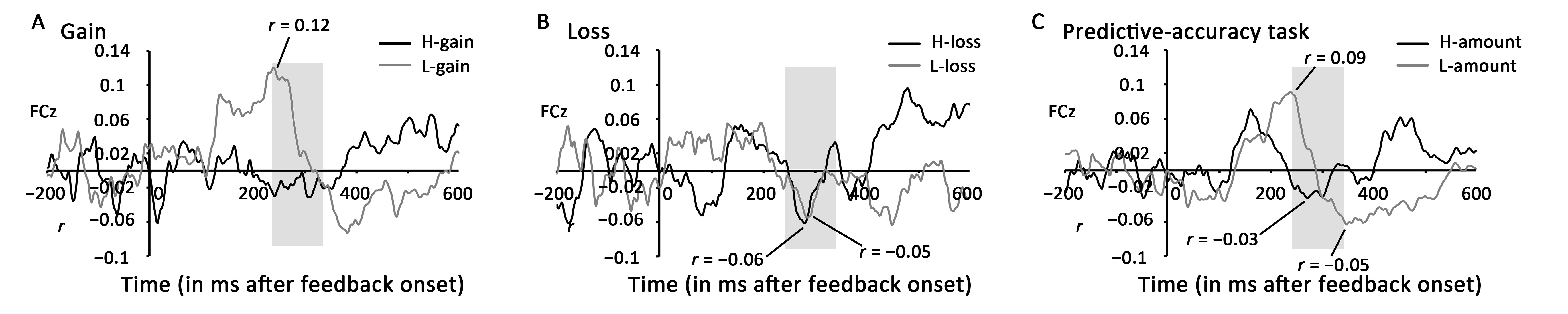

运用上述方法,本研究做了三个实验系统地调查了预期错误值是如何量化调节FRN的。在实验一中,反馈结果包含效价(好、坏)和预期违反(一致、不一致)两方面信息,但不对被试强调任何一方面信息,由被试自主反应(主要结果及解释见图2)。在实验二中,反馈结果只包含预期违反信息,同样由被试自主反应(主要结果及解释见图3)。实验三与实验一相似,均包含结果效价和预期违反,但被试不再是自主反应,而是需要根据任务指导,分别根据结果效价和预期违反来完成任务(主要结果及解释见图4)。

图2:实验一预期错误与脑电单试次相关分析结果。左图为获益条件下的结果,右图为损失条件下结果。整体上,获益时小于EV(L-gain),和损失时小于EV(L-loss)的预期错误值,均与FRN呈正相关。另一方面,获益时大于EV(H-gain),和损失时大于EV(H-loss)的预期错误值,均与FRN呈负相关。这个结果模式符合预期违反模型的预测(见图1右),因此实验一的结果倾向于支持预期违反模型。对于这个结果,我们猜测,虽然实验一没有要求被试根据结果效价还是预测准确性来做反应,但由于任务较难,被试需要关注其预测的准确性以寻找反应规律,因此导致结果更支持预期违反模型。

图3:实验二预期错误与脑电单试次相关分析结果。如图2注释所分析,实验二的结果与预期违反模型的预测相吻合。由于实验二中的数字仅仅反映数字大小,不涉及结果效价,被试的反应主要反映了预测的准确性。

图4:实验三预期错误与脑电单试次相关分析结果。如图2注释所分析,实验三结果显示,当强调结果效价(明确告知被试预测准确性不影响最后结果,只需要关注反馈结果的大小)时,出现了不对称结果(图A、B),支持强化学习模型(见图1左)。而当强调预期准确性(预测的越准,奖励越多)时,出现了对称的结果(图C),支持预期违反模型(见图1右)。

综合上述实验结果可知,反馈相关负波对结果的效价和预期违背信息都敏感,其反应取决于关注的是哪个维度的信息。具体来说,当强调预期的准确性时,个体主要关注的是预期是否违背,此时的FRN反映了预期违反信号;而当结果的效价被强调时,奖赏效应与预期违反信号将相互作用,反映了强化学习信号。该研究系统全面地证明了反馈结果效价与预期违背的评价机制,澄清了先前研究中存有争议的发现,加深了我们对适应性反应机制的理解。该研究最近被神经科学领域著名学术期刊《大脑皮层》(Cerebral Cortex)正式接受。

陈安涛教授为通讯作者,第一作者古焱为西南大学在读博士研究生。本研究得到国家自然科学基金项目(批准号:61431013,31771254)以及中央高校基本科研业务费科研项目(SWU1609106,SWU1709107,SWU1909567)资助。

论文信息:

Gu Y (古焱), Liu T (刘天亮), Zhang X (张雪萌), Long Q (龙泉杉), Hu N (胡娜), Zhang Y (张毅), Chen A (陈安涛). 2020. The event-related potentials responding to outcome valence and expectancy violation during feedback processing. Cerebral Cortex. DOI: 10.1093/cercor/bhaa274.